Indhold

- Big Data er ustruktureret eller halvstruktureret

- Der er ingen mening med at gemme Big Data, hvis vi ikke kan behandle dem

- Hvordan Hadoop løser Big Data-problemet

- Business sag til Hadoop

Tag væk:

Hadoop kan hjælpe med at løse nogle af store datas store udfordringer.

Big data er ... godt ... stor i størrelse! Præcis hvor meget data, der kan klassificeres som big data, er ikke meget entydigt, så vi kan ikke blive klædet i debatten. For et lille firma, der er vant til at håndtere data i gigabyte, ville 10 TB data være BIG. For virksomheder som Yahoo er petabytes imidlertid store.Blot størrelsen på big data gør det umuligt (eller i det mindste omkostningsforbudeligt) at gemme dem i traditionel opbevaring som databaser eller konventionelle filere. Vi taler om omkostninger til lagring af gigabyte med data. Brug af traditionelle lagringsfilere kan koste en masse penge til at gemme big data.

Her skal du se på big data, dens udfordringer og hvordan Hadoop kan hjælpe med at løse dem.Først op, store datas største udfordringer.

Big Data er ustruktureret eller halvstruktureret

En masse big data er ustruktureret. For eksempel kan data fra klikstrømloggen se ud:tidsstempel, bruger_ID, side, henviser_side

Manglende struktur gør relationelle databaser ikke velegnede til at gemme big data. Desuden kan ikke mange databaser klare lagring af milliarder rækker med data.

Der er ingen mening med at gemme Big Data, hvis vi ikke kan behandle dem

Lagring af big data er en del af spillet. Vi er nødt til at behandle det for at udnytte intelligensen ud af det. Traditionelle opbevaringssystemer er temmelig "stumme" i den forstand, at de bare opbevarer bits. De tilbyder ikke nogen processorkraft.Den traditionelle databehandlingsmodel har data, der er gemt i en lagringsklynge, der kopieres til en computerklynge til behandling. Resultaterne skrives tilbage til lagringsklyngen.

Denne model fungerer dog ikke ret til store data, fordi det kan være for tidskrævende eller umuligt at kopiere så meget data til en computerklynge. Så hvad er svaret?

En løsning er at behandle big data på plads, f.eks. I en lagringsklynge, der fungerer som en computerklynge.

Så som vi har set ovenfor, trodser big data traditionel opbevaring. Så hvordan håndterer vi big data?

Hvordan Hadoop løser Big Data-problemet

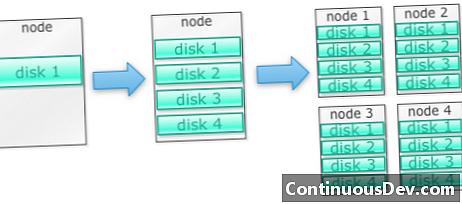

Hadoop er bygget til at køre på en klynge af maskinerLad os starte med et eksempel. Lad os sige, at vi er nødt til at gemme masser af fotos. Vi starter med en enkelt disk. Når vi overskrider en enkelt disk, kan vi bruge et par diske, der er stablet på en maskine. Når vi maksimerer alle diske på en enkelt maskine, er vi nødt til at få en masse maskiner, hver med en masse diske.

Dette er præcis, hvordan Hadoop er bygget. Hadoop er designet til at køre på en klynge af maskiner fra start.

Hadoop-klynger skalereres vandret

Mere lagring og computerkraft kan opnås ved at tilføje flere noder til en Hadoop-klynge. Dette eliminerer behovet for at købe mere og mere kraftfuld og dyre hardware.

Hadoop kan håndtere ustrukturerede / semistrukturerede data

Hadoop håndhæver ikke et skema for de data, det gemmer. Det kan håndtere vilkårlige og binære data. Så Hadoop kan nemt fordøje alle ustrukturerede data.

Hadoop-klynger giver lager og computing

Vi så, hvordan det at have separate lagrings- og behandlingsklynger ikke er bedst egnet til big data. Hadoop-klynger leverer dog lagring og distribueret computing alt sammen.

Business sag til Hadoop

Hadoop leverer lagring til big data til rimelige omkostninger

Det kan være dyrt at gemme store data ved hjælp af traditionel opbevaring. Hadoop er bygget omkring råvarehardware, så det kan give en forholdsvis stor lagerplads til en rimelig pris. Hadoop er blevet brugt i marken i petabyte skala.

En undersøgelse foretaget af Cloudera antydede, at virksomheder normalt bruger omkring $ 25.000 til $ 50.000 pr. Terabyte om året. Med Hadoop falder denne pris til et par tusind dollars pr. Terabyte om året. Når hardware bliver billigere og billigere, falder disse omkostninger fortsat.

Hadoop giver mulighed for indhentning af nye eller flere data

Nogle gange fanger organisationer ikke en type data, fordi det var for omkostningsforbudende at gemme dem. Da Hadoop leverer lagring til en rimelig pris, kan denne type data indfanges og gemmes.

Et eksempel ville være klikklogfiler på webstedet. Da volumen af disse logfiler kan være meget høj, er der ikke mange organisationer, der fanges disse. Nu med Hadoop er det muligt at fange og gemme logfiler.

Med Hadoop kan du gemme data længere

For at administrere mængden af lagrede data renser virksomheder med jævne mellemrum ældre data. For eksempel kunne kun logfiler i de sidste tre måneder gemmes, mens ældre logfiler blev slettet. Med Hadoop er det muligt at gemme de historiske data længere. Dette gør det muligt at udføre nye analyser på ældre historiske data.

Tag f.eks. Kliklogfiler fra et websted. For nogle få år siden blev disse logfiler gemt i en kort periode for at beregne statistikker som populære sider. Nu med Hadoop er det levedygtigt at gemme disse kliklogfiler i længere tid.

Hadoop leverer skalerbar analyse

Der er ingen mening i at gemme alle disse data, hvis vi ikke kan analysere dem. Hadoop leverer ikke kun distribueret opbevaring, men også distribueret behandling, hvilket betyder, at vi parallelt kan knuse en stor mængde data. Den beregnede ramme for Hadoop kaldes MapReduce. MapReduce er bevist efter størrelsen på petabytes.

Hadoop leverer rig analyse

Native MapReduce understøtter Java som et primært programmeringssprog. Andre sprog som Ruby, Python og R kan også bruges.

At skrive brugerdefineret MapReduce-kode er naturligvis ikke den eneste måde at analysere data i Hadoop. Kortnedsættelse på højere niveau er tilgængelig. For eksempel tager et værktøj, der hedder Pig, engelsk som datastrømsprog og oversætter dem til MapReduce. Et andet værktøj, Hive, tager SQL-forespørgsler og kører dem ved hjælp af MapReduce.

Business intelligence-værktøjer (BI) kan give endnu større analyseniveau. Der er også værktøjer til denne type analyse.

Dette indhold er uddraget fra "Hadoop Illuminated" af Mark Kerzner og Sujee Maniyam. Det er gjort tilgængeligt via Creative Commons Attribution-NonCommercial-ShareAlike 3.0 Unported-licens.