Indhold

Q:

Hvorfor er kunstige tilbagevendende neurale netværk ofte svære at træne?

EN:

Problemer med at træne kunstige tilbagevendende neurale netværk har at gøre med deres kompleksitet.

En af de enkleste måder at forklare, hvorfor tilbagevendende neurale netværk er svære at træne, er, at de ikke er fremadrettede neurale netværk.

I feedforward neurale netværk bevæger signaler kun en vej. Signalet bevæger sig fra et inputlag til forskellige skjulte lag og fremad til outputsystemet i et system.

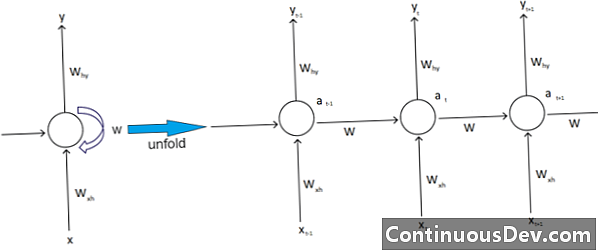

I modsætning hertil har tilbagevendende neurale netværk og andre forskellige typer neurale netværk mere komplekse signalbevægelser. Klassificeret som "feedback" netværk, tilbagevendende neurale netværk kan have signaler, der kører både fremad og tilbage, og kan indeholde forskellige "loops" i netværket, hvor numre eller værdier føres tilbage til netværket. Eksperter forbinder dette med aspektet af tilbagevendende neurale netværk, der er forbundet med deres hukommelse.

Derudover er der en anden type kompleksitet, der påvirker tilbagevendende neurale netværk. Et fremragende eksempel på dette er inden for behandling af naturligt sprog.

Ved sofistikeret naturlig sprogbehandling skal det neurale netværk være i stand til at huske ting. Det er nødvendigt at tage input i con, også. Antag, at der er et program, der ønsker at analysere eller forudsige et ord i en sætning med andre ord. Der kan for eksempel være en fast længde på fem ord for systemet at evaluere. Det betyder, at det neurale netværk skal have input til hvert af disse ord, sammen med evnen til at "huske" eller træne i disse ord. Af disse og andre lignende grunde har tilbagevendende neurale netværk typisk disse små skjulte sløjfer og feedbacks i systemet.

Eksperter klager over, at disse komplikationer gør det vanskeligt at træne netværkene. En af de mest almindelige måder at forklare dette på er ved at citere det eksploderende og forsvindende gradientproblem. Væsentligt vil netværkets vægter enten føre til eksploderende eller forsvindende værdier med et stort antal passeringer.

Neurale netværkspionerer Geoff Hinton forklarer dette fænomen på nettet ved at sige, at bagudgående lineære passager får mindre vægte til at krympe eksponentielt og større vægter eksploderer.

Dette problem, fortsætter han, bliver værre med lange sekvenser og flere talrige trin, hvor signalerne vokser eller henfalder. Vægtinitialisering kan hjælpe, men disse udfordringer er indbygget i den tilbagevendende neurale netværksmodel. Der vil altid være det problem knyttet til deres særlige design og opbygning. Grundlæggende trodser nogle af de mere komplekse typer af neurale netværk virkelig vores evne til let at administrere dem. Vi kan skabe en praktisk uendelig mængde kompleksitet, men vi ser ofte udfordrings- og skalerbarhedsudfordringer vokse.